1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

53

54

55

56

57

58

59

60

61

62

63

64

65

66

67

68

69

70

71

72

73

74

75

76

77

|

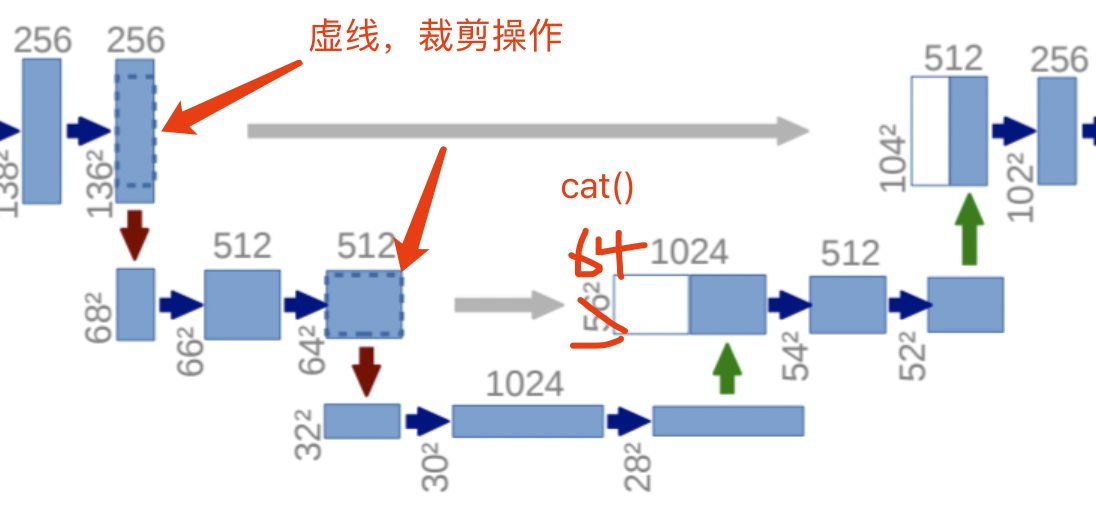

import torch as t

from torch import nn

## 下采样的基本结构

# 参考:https://github.com/JavisPeng/u_net_liver/blob/a1b9553d8ba8c6e5a3d4c5fabd387e130e60a072/dataset.py#L16

# 常用的两个卷积操作简单封装

class DoubleConv(nn.Module):

def __init__(self, in_ch, out_ch):

super().__init__()

self.conv_down = nn.Sequential(

# 主流实现方式

# - 在3x3的卷积层加上一个padding(也就是每次经过这个3x3的卷积层的时候不会去改变特征层的高和宽)

# - 在卷积核ReLU之间加BatchNormalization

nn.Conv2d(in_ch, out_ch, 3, padding=1),

nn.BatchNorm2d(out_ch),

nn.ReLU(inplace=True),

nn.Conv2d(in_ch, out_ch, 3, padding=1),

nn.BatchNorm2d(out_ch),

nn.ReLU(inplace=True),

)

def forward(self, input):

return self.conv_down(input)

# U-Net网络

class Unet(nn.Module):

def __init__(self, in_ch, out_ch):

super().__init__()

# 下采样

self.conv1 = DoubleConv(in_ch, 64)

self.pool1 = nn.MaxPool2d(2)

self.conv2 = DoubleConv(64, 128)

self.pool2 = nn.MaxPool2d(2)

self.conv3 = DoubleConv(128, 256)

self.pool3 = nn.MaxPool2d(2)

self.conv4 = DoubleConv(256, 512)

self.pool4 = nn.MaxPool2d(2)

self.conv5 = DoubleConv(512, 1024)

# 上采样

# 转置卷积(有参数可以训练)可以实现上采样,也可以使用Upsample上采样(通过插值完成,没有训练参数,速度更快)(保证k=stride,stride即上采样倍数)

self.up6 = nn.ConvTranspose2d(1024, 512, 2, stride=2)

self.conv6 = DoubleConv(1024, 512)

self.up7 = nn.ConvTranspose2d(512, 256, 2, stride=2)

self.conv7 = DoubleConv(512, 256)

self.up8 = nn.ConvTranspose2d(256, 128, 2, stride=2)

self.conv8 = DoubleConv(256, 128)

self.up9 = nn.ConvTranspose2d(128, 64, 2, stride=2)

self.conv9 = DoubleConv(128, 64)

self.conv10 = nn.Conv2d(64, out_ch, 1)

def forward(self, x):

c1 = self.conv1(x)

p1 = self.pool1(c1)

c2 = self.conv2(p1)

p2 = self.pool2(c2)

c3 = self.conv3(p2)

p3 = self.pool3(c3)

c4 = self.conv4(p3)

p4 = self.pool4(c4)

c5 = self.conv5(p4)

up_6 = self.up6(c5)

merge6 = t.cat([up_6, c4], dim=1) # cat 拼接

c6 = self.conv6(merge6) # 对拼接之后的继续向上进行卷积

up_7 = self.up7(c6)

merge7 = t.cat([up_7, c3], dim=1)

c7 = self.conv7(merge7)

up_8 = self.up8(c7)

merge8 = t.cat([up_8, c2], dim=1)

c8 = self.conv8(merge8)

up_9 = self.up9(c8)

merge9 = t.cat([up_9, c1], dim=1)

c9 = self.conv9(merge9)

c10 = self.conv10(c9)

out = nn.Sigmoid()(c10)

return out

|

说明几点先:

说明几点先: